Wie funktionieren mit Künstlicher Intelligenz (KI) erzeugte Fakes, welche Narrative zeigen sie und wie gefährlich sind sie? DW-Faktencheck beantwortet die wichtigsten Fragen zur Rolle von KI in dem Konflikt zwischen Israel und der Hamas in Gaza.

1) Wie funktionieren KI-generierte Fakes?

KI ist inzwischen überall – auch im Krieg. Die Anwendbarkeit Künstlicher Intelligenz hat sich in diesem Jahr stark verbessert. Fast jeder kann mittlerweile mithilfe gängiger KI-Generatoren Bilder erstellen, die zumindest auf den ersten Blick echt wirken.

Dafür müssen Nutzende Tools wie Midjourney oder Dall-E mit Prompts, also Vorgaben und Informationen, „füttern“. Sie wandeln diese dann zu Bildern um. Manche erzeugen dabei eher künstlerische Illustrationen, andere erschaffen fotorealistische Bildnisse. Der Erzeugungsprozess basiert auf so genanntem maschinellem Lernen. Beauftragt man die Generatoren etwa damit, einen 70-jährigen Mann beim Fahrradfahren zu zeigen, durchforsten sie dafür ihre Datenbank, in der Texte mit Bildern gepaart sind. Auf Basis der dort verfügbaren Informationen erstellen die KI-Generator das Bild des älteren Radfahrers. Durch immer mehr Input und technische Verbesserungen haben sich die Tools in den vergangenen Jahren und Monaten stark verbessert – und sie lernen laufend dazu.

So funktioniert es auch im Fall der Bilder zum Nahostkonflikt. Auch hier nutzen Anwender die Tools, um mehr oder wenige realistische Szenen zu kreieren. Nach unseren Beobachtungen bilden die KI-Fakes oft emotionale Momente ab, um so bestimmte Narrative zu verbreiten – dazu später mehr. In diesem Konflikt, „in dem die Emotionen sehr, sehr hochkochen“, so KI-Experte Hany Farid, funktioniere Desinformation, unter anderem mittels KI-Bildern, besonders gut. Derart verhärtete Fronten seien der perfekte Nährboden, um gefälschte Inhalte zu erstellen, zu verbreiten und die Emotionen noch zu verstärken, sagt Farid, der an der kalifornischen Berkeley-Universität als Professor für digitale Forensik tätig ist.

2) Wie viele KI-Bilder zirkulieren im Israel-Hamas-Krieg?

Bereits im Ukraine-Krieg haben Bilder und Videos, die mithilfe künstlicher Intelligenz erstellt wurden, einen Teil zur Desinformation beigetragen – und tun es weiterhin. Weil sich KI-Tools zuletzt rasant weiterentwickelt haben, erwarteten viele Beobachter eine noch größere Präsenz von KI im Israel-Hamas-Krieg. Doch Expertinnen und Experten zufolge ist die große Flut an KI-Bildern ausgeblieben – bisher.

„Wir sehen keinen massiven Einsatz von KI-generierten Bildern“, sagt etwa Tommaso Canetta von der Europäischen Beobachtungsstelle für digitale Medien. „Die Menge ist eher gering, wenn wir sie mit anderen Formen der Desinformation vergleichen, etwa alte Bilder und alte Videos, die jetzt auf irreführende Weise erneut verbreitet werden.“ Das heißt jedoch nicht, dass die Technologie keine Rolle spielt.

Experte Hany Farid erklärt im DW-Gespräch, er halte die Anzahl von KI-Fakes nicht für die relevante Größe. „Nur zwei Bilder, die viral gehen und von Hunderten von Millionen Menschen gesehen werden, können eine enorme Wirkung haben.“ Die Wirkkraft von KI-Fakes und anderen Formen der Desinformation bestehe vor allem darin, dass sie „das Informations-Ökosystem verschmutzen“.

3) Welche Narrative bedienen die KI-Fakes im Israel-Hamas-Krieg?

Die in sozialen Netzwerken zirkulierenden KI-Bilder sind meist dazu geeignet, starke Emotionen bei den Betrachtenden auszulösen. Der Experte Canetta macht zwei hauptsächliche Kategorien aus: Bilder, die das Leid der Zivilbevölkerung in den Vordergrund stellen und Mitleid mit den gezeigten Personen erregen. Und KI-Fakes, die die Unterstützung entweder für Israel oder für die Hamas beziehungsweise die Palästinenser übertrieben darstellen und an patriotische Gefühle appellieren.

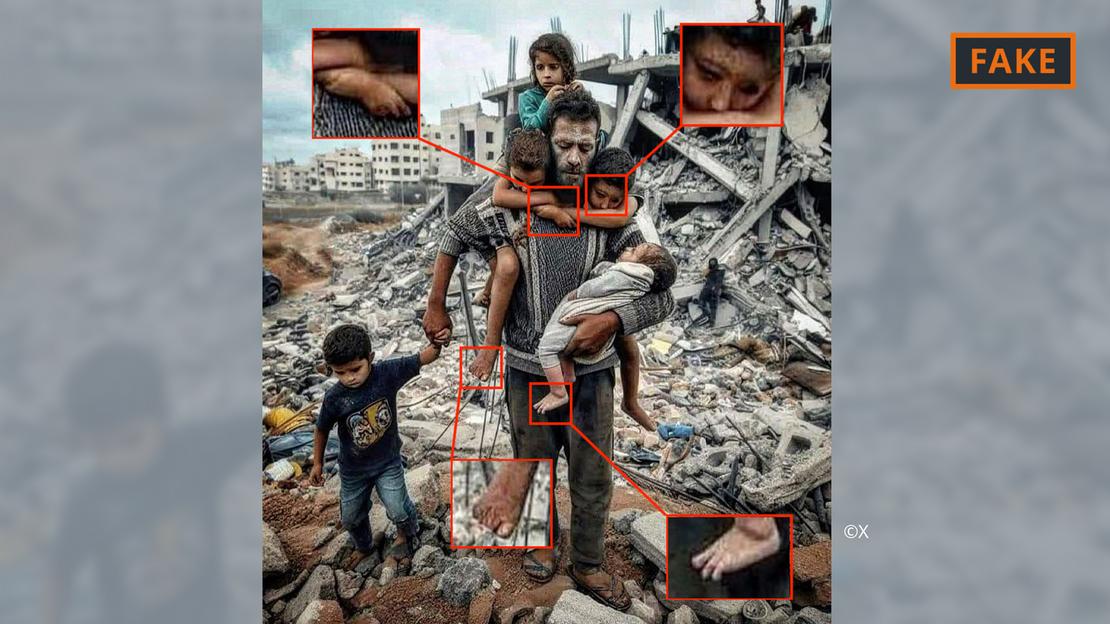

In die erste Kategorie fällt zum Beispiel das obenstehende Bild eines Vaters mit seinen fünf Kindern vor einem Trümmerberg, das im Zusammenhang mit Israels Bombardierung des Gazastreifens viele Male auf X (ehemals Twitter)

oder Instagram geteilt und hunderttausendfach gesehen wurde. Mittlerweile ist das Bild zumindest auf X mit einem Community-Hinweis versehen, dass es sich um ein Fake handelt. Als solches zu erkennen ist es anhand verschiedener Fehler und Unstimmigkeiten, die für KI-Bilder (noch) typisch sind.

So liegt die rechte Schulter des Mannes unproportional weit oben. Die darunter hervorkommenden zwei Gliedmaßen sind ebenfalls seltsam – als wüchsen sie aus dem Pullover heraus. Auch auffällig: Die Hände der beiden Jungen, die ihre Arme um den Hals des Vaters geschlungen haben, verschmelzen miteinander. Und bei mehreren Händen und Füßen im Bild sind zu viele oder zu wenige Finger und Zehen vorhanden.

Ähnliche Auffälligkeiten lassen sich auch bei folgendem auf X viral gegangenen KI-Fake

ausmachen, das eine palästinensische Familie beim gemeinsamen Essen in den Trümmern zeigen soll.

In die zweite Kategorie fällt das unten stehende Bild, auf dem Soldaten israelische Flaggen schwenkend durch eine Siedlung voller zerbombter Häuser laufen. Die Accounts, die das Bild etwa auf Instagram und X verbreiten

, scheinen zumeist pro-israelisch eingestellt zu sein und das dargestellte Geschehen zu begrüßen. DW hat das Bild auch als Artikelbild in einer bulgarischen Online-Zeitung

gefunden, die es nicht als KI-generiert erkannt beziehungsweise gekennzeichnet hat.

Was hier unecht wirkt, ist etwa, wie die israelischen Flaggen wehen. Zudem erscheint die Straße in der Mitte zu sauber, während der Schutt sehr gleichförmig aussieht. Auch die zerstörten Gebäude wirken wie Zwillinge, die in recht regelmäßigen Abständen stehen. Alles in allem ist der visuelle Eindruck zu „clean“, um realistisch zu wirken. Eine solche Makellosigkeit, die Bilder wie gemalt wirken lässt, ist ebenfalls KI-typisch.

4) Woher kommen die KI-Bilder?

Die meisten mithilfe von künstlicher Intelligenz erstellten Bilder werden von Privataccounts auf Social Media verbreitet. Sie werden sowohl von authentischen als auch von offensichtlich falschen Profilen gepostet. Jedoch können KI-generierte Bilder auch im Journalismus eingesetzt werden. Ob und in welchen Fällen das nützlich oder sinnvoll sein kann, wird derzeit in vielen Medienhäusern diskutiert.

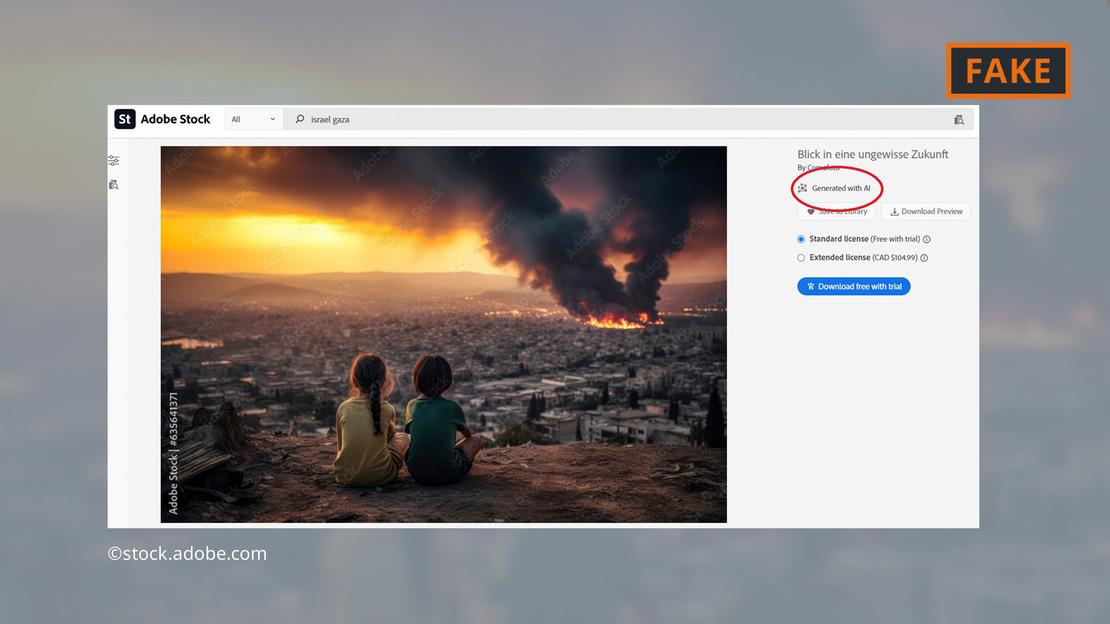

Aufsehen erregte nun das Softwareunternehmen Adobe, welches Ende 2022 KI-generierte Bilder in sein Angebot von Stock-Fotos aufgenommen

hat. Diese sind in der Datenbank mit einem entsprechenden Hinweis versehen.

Nun bietet Adobe dort auch KI-Bilder zum Nahost-Krieg

zum Verkauf an – etwa von Explosionen, protestierenden Menschen oder Rauschschwaden hinter der Al-Aqsa-Moschee. Kritiker finden das höchst fragwürdig. Und einige Online-Seiten und Medien haben die Bilder weiterverwendet, ohne sie dabei als KI-generiert zu kennzeichnen – das obenstehende Bild etwa taucht unter anderem ohne jeglichen Hinweis auf der Seite „Newsbreak“ auf. Das haben wir mithilfe einer Bilderrückwärtssuche

herausgefunden.

Sogar der „European Parliamentary Research Service“, der Wissenschaftliche Dienst des Europäischen Parlaments, illustriert einen Onlinetext zum Nahost-Konflikt mit einem der Fakes

aus der Adobe-Datenbank

– wiederum ohne eine Kennzeichnung als KI-generiertes Bild.

Tommaso Canetta von der Europäischen Beobachtungsstelle für digitale Medien appelliert an Journalisten und Medienschaffende, sehr vorsichtig mit KI-Bildern umzugehen. Besonders bei realen Geschehnissen wie dem Nahost-Krieg rät er davon ab. Anders sei es, wenn es um die Bebilderung abstrakter Themen wie etwa Zukunftstechnologien gehe.

5) Wie viel Schaden richten KI-Bilder an?

Das Wissen, dass KI-Inhalte im Umlauf sind, führt dazu, dass Nutzende unsicher bei allem werden, was ihnen online begegnet. Der Berkeley-Forscher Farid erklärt: „Die Möglichkeit, Bilder, Audio- und Videomaterial zu manipulieren, führt dazu, dass alles in Frage gestellt wird.“ Mitunter passiere es dann etwa auch, dass echte Bilder fälschlicherweise als unauthentisch gebrandmarkt werden.

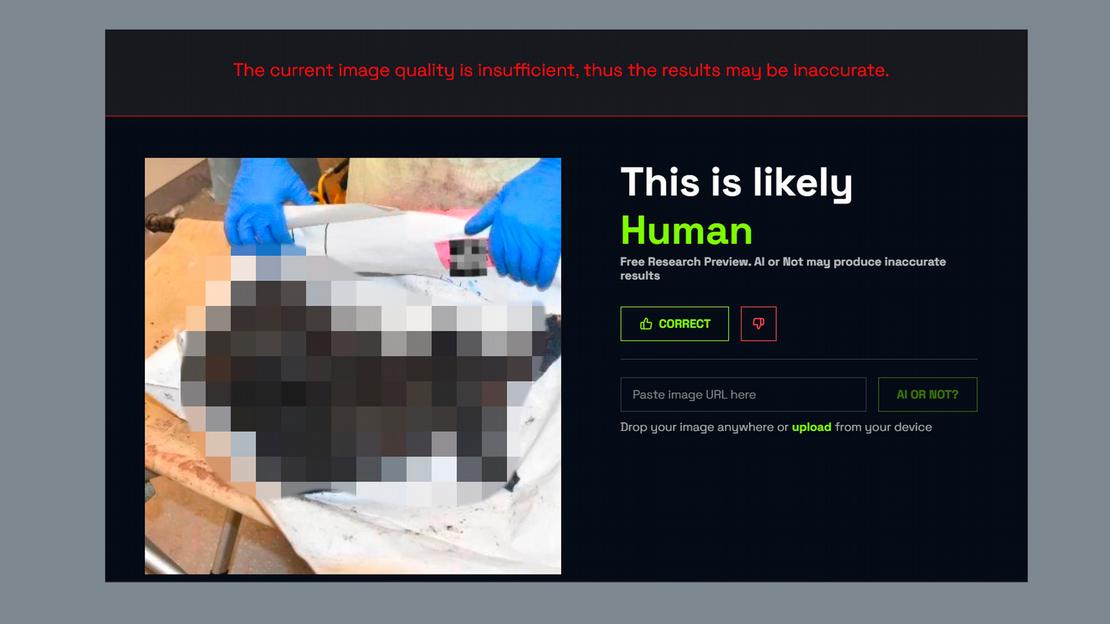

So geschehen in diesem Fall: Ein Bild, das die verkohlte Leiche eines israelischen Babys zeigen soll, wurde unter anderem von Israels Premierminister Benjamin Netanjahu und dem konservativen US-amerikanischen Kommentator Ben Shapiro auf X geteilt. Daraufhin behauptete der umstrittene anti-israelische Influencer Jackson Hinkle, das Bild sei mit Künstlicher Intelligenz erstellt worden.

Als angeblichen Beweis fügte Hinkle seinem Post den Screenshot des KI-Detektors „AI or not“ bei, der das Bild als KI-generiert eingestuft habe. Hinkles Behauptung auf X wurde mehr als 20 Millionen Mal gesehen und führte zu hitzigen Diskussionen auf X. Letztendlich konstatierten viele, dass das Bild aller Wahrscheinlichkeit nach doch echt sei und Hinkle somit falsch liege. Auch Hany Farid erklärt gegenüber der DW, er habe keine Unstimmigkeiten im Bild feststellen können, die auf ein KI-Fake hinweisen würden.

Wie das sein kann? KI-Detektoren, mit deren Hilfe man prüfen kann, ob ein Bild oder Text möglicherweise KI-generiert ist, sind noch sehr fehleranfällig. Je nach überprüftem Bild geben sie korrekte oder nicht zutreffende Urteile ab, oft auch nur mit einer Wahrscheinlichkeitsangabe, keiner hundertprozentigen Aussage. Deshalb eignen sie sich bestenfalls als zusätzliches, aber nicht als einziges Tool zur Überprüfung von KI-Fakes.

Das DW-Faktencheck-Team kann ebenfalls keine eindeutigen Anzeichen von KI-basierter Manipulation in dem Bild feststellen, das mutmaßlich eine Babyleiche zeigt. Kurioserweise stuft „AI or not“ das Bild, als wir es selbst ausprobieren, nicht als KI-generiert ein – und weist darauf hin, die Bildqualität sei schlecht. Ein weiterer KI-Detektor (Hive moderation) kommt ebenfalls zu dem Ergebnis, das Bild sei echt.